Neste guia, você aprenderá:

- O que é o Pydoll e os recursos que ele oferece

- Como usá-lo para extrair sites com JavaScript

- Como contornar a proteção da Cloudflare

- Suas maiores limitações

- Como superar essas limitações usando a integração de proxy rotativo

- As principais alternativas baseadas em Python para o Pydoll

Vamos mergulhar de cabeça!

Uma introdução ao Pydoll

Descubra o que é o Pydoll, como ele funciona e o que ele oferece como uma biblioteca de raspagem da Web em Python.

O que é

O Pydoll é uma biblioteca de automação de navegador Python criada para raspagem da Web, testes e automação de tarefas repetitivas. O que a diferencia é que ela elimina a necessidade de drivers tradicionais da Web. Em detalhes, ela se conecta diretamente aos navegadores por meio do protocolo DevTools, sem necessidade de dependências externas.

A primeira versão estável do Pydoll, a versão 1.0, foi lançada em fevereiro de 2026. Isso o torna um participante relativamente novo no espaço de raspagem da Web. Apesar disso, ele já ganhou um grande impulso, conquistando mais de 3.000 estrelas no GitHub:

Como você pode ver, a biblioteca está ganhando muita popularidade na comunidade de raspagem da Web em Python.

Recursos

Aqui está um resumo dos principais recursos oferecidos pelo Pydoll:

- Zero webdrivers: Elimina a dependência do driver do navegador, reduzindo os problemas de incompatibilidade de versão e simplificando a configuração da automação baseada no Chromium.

- Arquitetura Async-first: Construído inteiramente em asyncio para alta simultaneidade, uso eficiente de memória e padrões modernos de desenvolvimento Python.

- Interações semelhantes às humanas: Imita a digitação realista, os movimentos do mouse e os cliques para reduzir a detecção de bots durante a automação.

- Recursos orientados por eventos: Permite a reação em tempo real a eventos de navegador, DOM, rede e ciclo de vida para automação responsiva.

- Suporte a vários navegadores: Compatível com o Chrome, o Edge e outros navegadores Chromium usando a mesma interface unificada.

- Captura de tela e exportação de PDF: Capture páginas inteiras, elementos específicos ou gere PDFs de alta qualidade a partir de qualquer página da Web carregada.

- Bypass nativo da Cloudflare: Ignora automaticamente o antibot da Cloudflare sem serviços de terceiros, imitando sessões de navegador confiáveis quando a reputação do IP é alta.

- Raspagem simultânea: Faz a raspagem de várias páginas ou sites em paralelo, reduzindo drasticamente o tempo total de execução.

- Controle avançado do teclado: Simula a digitação real do usuário com controle preciso sobre o tempo, os modificadores e o manuseio de teclas especiais.

- Sistema avançado de eventos: Oferece monitoramento e tratamento em tempo real de solicitações de rede, carregamentos de página e eventos personalizados do navegador.

- Suporte a upload de arquivos: Automatiza o upload de arquivos usando tanto a entrada direta quanto as caixas de diálogo interativas do seletor de arquivos.

- Integração de proxy: Oferece suporte ao uso de proxy para rotação de IP, segmentação geográfica ou para evitar limites de taxa durante a raspagem.

- Interceptação de solicitações: Intercepte, modifique ou bloqueie solicitações e respostas HTTP para automação avançada e controle de raspagem.

Saiba mais na documentação oficial.

Uso do Pydoll para raspagem da Web: Tutorial completo

Nesta seção do tutorial, você aprenderá a usar o Pydoll para extrair dados da versão assíncrona e com tecnologia JavaScript do “Quotes to Scrape“:

Essa página renderiza dinamicamente os elementos de cotação usando JavaScript após um pequeno atraso. Portanto, as ferramentas de raspagem tradicionais não funcionarão imediatamente. Para extrair o conteúdo dessa página, você precisa de uma ferramenta de automação do navegador, como o Pydoll.

Siga as etapas abaixo para criar um raspador da Web Pydoll que extrai dinamicamente dados de citações de “Quotes to Scrape”.

Etapa 1: Configuração do projeto

Antes de começar, certifique-se de que você tenha o Python 3+ instalado em seu computador. Caso contrário, faça o download e siga as instruções de instalação.

Em seguida, execute o seguinte comando para criar uma pasta para seu projeto de raspagem:

mkdir pydoll-scraperO diretório pydoll-scraper servirá como a pasta do projeto.

Navegue até a pasta em seu terminal e inicialize um ambiente virtual Python dentro dela:

cd pydoll-scraper

python -m venv venvCarregue a pasta do projeto em seu IDE Python favorito. O Visual Studio Code com a extensão Python ou o PyCharm Community Edition são suficientes.

Crie um arquivo scraper.py na pasta do projeto, que agora deve conter:

Neste momento, o scraper.py é apenas um script Python vazio. Ainda assim, em breve ele conterá a lógica de análise de dados.

Em seguida, ative o ambiente virtual no terminal do seu IDE. No Linux ou macOS, execute:

source venv/bin/activateDe forma equivalente, no Windows, inicie:

venv/Scripts/activateMaravilhoso! Seu ambiente Python agora está configurado para raspagem da Web com o Pydoll.

Etapa 2: Configurar o Pydoll

Em um ambiente virtual ativado, instale o Pydoll por meio do pacote pydoll-python:

pip install pydoll-pythonAgora, adicione a lógica abaixo ao arquivo scraper.py para começar a usar o Pydoll:

import asyncio

from pydoll.browser.chrome import Chrome

async def main():

async with Chrome() as browser:

# Launch the Chrome browser and open a new page

await browser.start()

page = await browser.get_page()

# scraping logic...

# Execute the async scraping function

asyncio.run(main())Observe que o Pydoll fornece uma API assíncrona para raspagem da Web e requer o uso da biblioteca padrão asyncio do Python.

Ótimo! Agora você tem um script básico do Pydoll instalado.

Etapa 3: Conectar-se ao site de destino

Chame o método go_to() fornecido pelo objeto de página para navegar até o site de destino:

await page.go_to("https://quotes.toscrape.com/js-delayed/?delay=2000")O parâmetro de consulta ?delay=2000 instrui a página a carregar os dados desejados dinamicamente após um atraso de 2 segundos. Esse é um recurso do site sandbox de destino, projetado para ajudar a testar o comportamento de raspagem dinâmica.

Agora, tente executar o script acima. Se tudo estiver funcionando corretamente, o Pydoll o fará:

- Iniciar uma instância do Chrome

- Navegue até o site de destino

- Feche a janela do navegador imediatamente, pois ainda não há lógica adicional no script

Especificamente, isso é o que você deve ser capaz de ver antes de ser fechado:

Perfeito! Você está pronto para adicionar a lógica de espera.

Etapa 4: Aguarde até que os elementos HTML apareçam

Dê uma olhada na última imagem da etapa anterior. Ela representa o conteúdo da página controlada pelo Pydoll na instância do Chrome. Você perceberá que ela está completamente em branco – nenhum dado foi carregado.

O motivo é que o site de destino renderiza dinamicamente os dados após um atraso de 2 segundos. Agora, esse atraso é específico do site de exemplo. Ainda assim, ter que esperar a renderização da página é um cenário comum ao raspar SPAs (aplicativos de página única) e outros sites dinâmicos que dependem de AJAX.

Saiba mais em nosso artigo sobre raspagem de sites dinâmicos com Python.

Para lidar com esse cenário comum, o Pydoll fornece mecanismos de espera incorporados por meio desse método:

wait_element(): Aguarda o aparecimento de um único elemento (com suporte a tempo limite)

O método acima oferece suporte a seletores CSS, expressões XPath e muito mais – semelhante ao funcionamento do objeto By do Selenium.

Agora é hora de se familiarizar com o HTML da página de destino. Portanto, abra-a no navegador, aguarde o carregamento das aspas, clique com o botão direito do mouse em uma das aspas e selecione a opção “Inspecionar”:

No painel DevTools, você verá que cada citação está envolvida em um

quote. Isso significa que você pode direcioná-las usando o seletor CSS:

.quoteAgora, use o Pydoll para esperar que esses elementos apareçam antes de continuar:

await page.wait_element(By.CSS_SELECTOR, ".quote", timeout=3)Não se esqueça de importar By:

from pydoll.constants import ByExecute o script novamente e, dessa vez, você verá que o Pydoll aguarda o carregamento dos elementos de citação antes de fechar o navegador. Bom trabalho!

Etapa 5: Prepare-se para o Web Scraping

Lembre-se de que a página de destino contém mais do que apenas uma citação. Como você deseja extrair todas elas, precisa de uma estrutura de dados para armazenar esses dados. Uma matriz simples funciona perfeitamente, portanto, inicialize uma:

quotes = []Para localizar elementos da página, o Pydoll oferece dois métodos úteis:

find_element(): Encontra o primeiro elemento correspondentefind_elements(): Encontra todos os elementos correspondentes

Assim como em wait_element(), esses métodos aceitam um seletor usando o objeto By.

Portanto, selecione todos os elementos de citação na página com:

quote_elements = await page.find_elements(By.CSS_SELECTOR, ".quote")Em seguida, percorra os elementos e prepare-se para aplicar sua lógica de raspagem:

for quote_element in quote_elements:

# Scraping logic...Excelente! Hora da lógica de extração de dados.

Etapa nº 6: implementar a lógica de análise de dados

Comece inspecionando um único elemento de citação:

Como você pode ver no HTML acima, um único elemento de citação contém:

- A citação de texto em um nó

.text - O autor no elemento

.author - Uma lista de tags nos elementos

.tag

Implemente a lógica de raspagem para selecionar esses elementos e extrair deles os dados de interesse:

# Extract the quote text (and remove curly quotes)

text_element = await quote_element.find_element(By.CSS_SELECTOR, ".text")

text = (await text_element.get_element_text()).replace("“", "").replace("”", "")

# Extract the author name

author_element = await quote_element.find_element(By.CSS_SELECTOR, ".author")

author = await author_element.get_element_text()

# Extract all associated tags

tag_elements = await quote_element.find_elements(By.CSS_SELECTOR, ".tag")

tags = [await tag_element.get_element_text() for tag_element in tag_elements]Observação: O método replace() remove as aspas duplas curvas desnecessárias do texto de citação extraído.

Agora, utilize os dados extraídos para preencher um novo objeto de dicionário e adicione-o à matriz de citações:

# Populate a new quote with the scraped data

quote = {

"text": text,

"author": author,

"tags": tags

}

# Append the extracted quote to the list

quotes.append(quote)Muito bem! Resta apenas exportar os dados extraídos para CSV.

Etapa nº 7: Exportar para CSV

Atualmente, os dados extraídos são armazenados em uma lista Python. Facilite o compartilhamento e a exploração com outras pessoas exportando-os para um formato legível por humanos, como CSV.

Use o Python para criar um novo arquivo chamado quotes.csv e preenchê-lo com os dados extraídos:

with open("quotes.csv", "w", newline="", encoding="utf-8") as csvfile:

# Add the header

fieldnames = ["text", "author", "tags"]

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

# Populate the output file with the scraped data

writer.writeheader()

for quote in quotes:

writer.writerow(quote)Lembre-se de importar csv da biblioteca padrão do Python:

import csvMissão concluída! Seu raspador Pydoll está pronto para ser executado.

Etapa #8: Juntar tudo

O arquivo scraper.py agora deve conter:

import asyncio

from pydoll.browser.chrome import Chrome

from pydoll.constants import By

import csv

async def main():

async with Chrome() as browser:

# Launch the Chrome browser and open a new page

await browser.start()

page = await browser.get_page()

# Navigate to the target page

await page.go_to("https://quotes.toscrape.com/js-delayed/?delay=2000")

# Wait up to 3 seconds for the quote elements to appear

await page.wait_element(By.CSS_SELECTOR, ".quote", timeout=3)

# Where to store the scraped data

quotes = []

# Select all quote elements

quote_elements = await page.find_elements(By.CSS_SELECTOR, ".quote")

# Iterate over them and scrape data from them

for quote_element in quote_elements:

# Extract the quote text (and remove curly quotes)

text_element = await quote_element.find_element(By.CSS_SELECTOR, ".text")

text = (await text_element.get_element_text()).replace("“", "").replace("”", "")

# Extract the author

author_element = await quote_element.find_element(By.CSS_SELECTOR, ".author")

author = await author_element.get_element_text()

# Extract all tags

tag_elements = await quote_element.find_elements(By.CSS_SELECTOR, ".tag")

tags = [await tag_element.get_element_text() for tag_element in tag_elements]

# Populate a new quote with the scraped data

quote = {

"text": text,

"author": author,

"tags": tags

}

# Append the extracted quote to the list

quotes.append(quote)

# Export the scraped data to CSV

with open("quotes.csv", "w", newline="", encoding="utf-8") as csvfile:

# Add the header

fieldnames = ["text", "author", "tags"]

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

# Populate the output file with the scraped data

writer.writeheader()

for quote in quotes:

writer.writerow(quote)

# Execute the async scraping function

asyncio.run(main())Uau! Em menos de 60 linhas de código, você pode criar um bot de raspagem da Web com o Pydoll.

Teste o script acima executando-o:

python scraper.pyQuando a execução terminar, um arquivo quotes.csv aparecerá na pasta do projeto. Abra-o e você verá os dados extraídos organizados de forma clara:

E pronto! Seu script de raspagem da Web Pydoll funciona como esperado.

Contornando o Cloudflare com o Pydoll

Ao interagir com um site em uma ferramenta de automação de navegador, um dos maiores desafios que você enfrentará são os firewalls de aplicativos da Web (WAFs). Pense em soluções como a Cloudflare, que geralmente vêm com proteções antibot avançadas.

Quando se suspeita que suas solicitações são provenientes de um navegador automatizado, esses sistemas geralmente exibem um CAPTCHA. Em alguns casos, eles o apresentam a todos os usuários durante a primeira visita ao site.

Contornar CAPTCHAs em Python não é uma tarefa fácil. No entanto, há maneiras de fazer com que o Cloudflare pense que você é um usuário real, de modo que ele não mostre um CAPTCHA em primeiro lugar. É aqui que entra o Pydoll, que fornece uma API dedicada para essa finalidade.

Para demonstrar como ele funciona, usaremos a página de teste “Antibot Challenge” do site ScrapingCourse:

Como você pode ver, a página sempre executa o Cloudflare JavaScript Challenge. Uma vez contornado, ele exibe alguns exemplos de conteúdo para confirmar que a proteção anti-bot foi derrotada.

O Pydoll apresenta duas abordagens para lidar com o Cloudflare:

- Abordagem do gerenciador de contexto: Lida com o desafio antibot de forma síncrona, pausando a execução do script até que o desafio seja resolvido.

- Abordagem de processamento em segundo plano: Lida com o antibot de forma assíncrona em segundo plano.

Abordaremos os dois métodos. No entanto, conforme mencionado nos documentos oficiais, lembre-se de que o desvio do Cloudflare nem sempre funciona. Isso se deve a questões como reputação do IP ou histórico de navegação.

Para obter técnicas mais avançadas, leia nosso tutorial completo sobre raspagem de sites protegidos pela Cloudflare.

Abordagem do gerenciador de contexto

Para permitir que o Pydoll lide automaticamente com o desafio anti-bot do Cloudflare para você, use o método expect_and_bypass_cloudflare_captcha() desta forma:

import asyncio

from pydoll.browser.chrome import Chrome

from pydoll.constants import By

async def main():

async with Chrome() as browser:

# Launch the Chrome browser and open a new page

await browser.start()

page = await browser.get_page()

# Wait for the Cloudflare challenge to be executed

async with page.expect_and_bypass_cloudflare_captcha():

# Connect to the Cloudflare-protected page:

await page.go_to("https://www.scrapingcourse.com/antibot-challenge")

print("Waiting for Cloudflare anti-bot to be handled...")

# This code runs only after the anti-bot is successfully bypassed

print("Cloudflare anti-bot bypassed! Continuing with automation...")

# Print the text message on the success page

await page.wait_element(By.CSS_SELECTOR, "#challenge-title", timeout=3)

success_element = await page.find_element(By.CSS_SELECTOR, "#challenge-title")

success_text = await success_element.get_element_text()

print(success_text)

asyncio.run(main())Quando você executar esse script, a janela do Chrome ignorará automaticamente o desafio e carregará a página de destino.

O resultado será:

Waiting for Cloudflare anti-bot to be handled...

Cloudflare anti-bot bypassed! Continuing with automation...

You bypassed the Antibot challenge! 😀Abordagem de processamento em segundo plano

Se você preferir não bloquear a execução do script enquanto o Pydoll lida com o desafio do Cloudflare, poderá usar os métodos enable_auto_solve_cloudflare_captcha() e disable_auto_solve_cloudflare_captcha() da seguinte forma:

import asyncio

from pydoll.browser import Chrome

from pydoll.constants import By

async def main():

async with Chrome() as browser:

# Launch the Chrome browser and open a new page

await browser.start()

page = await browser.get_page()

# Enable automatic captcha solving before navigating

await page.enable_auto_solve_cloudflare_captcha()

# Connect to the Cloudflare-protected page:

await page.go_to("https://www.scrapingcourse.com/antibot-challenge")

print("Page loaded, Cloudflare anti-bot will be handled in the background...")

# Disable anti-bot auto-solving when no longer needed

await page.disable_auto_solve_cloudflare_captcha()

# Print the text message on the success page

await page.wait_element(By.CSS_SELECTOR, "#challenge-title", timeout=3)

success_element = await page.find_element(By.CSS_SELECTOR, "#challenge-title")

success_text = await success_element.get_element_text()

print(success_text)

asyncio.run(main())Essa abordagem permite que seu raspador execute outras operações enquanto o Pydoll resolve o desafio anti-bot do Cloudflare em segundo plano.

Dessa vez, o resultado será:

Page loaded, Cloudflare anti-bot will be handled in the background...

You bypassed the Antibot challenge! 😀Limitações dessa abordagem de raspagem da Web

Com o Pydoll – ou qualquer ferramenta de raspagem – sevocê enviar muitas solicitações, há uma boa chance de ser bloqueado pelo servidor de destino. Isso ocorre porque a maioria dos sites implementa limitação de taxa para evitar que os bots (como seu script de raspagem) sobrecarreguem seus servidores com solicitações.

Essa é uma técnica comum de anti-scraping e anti-DDoS. Afinal de contas, ninguém quer que seu site seja inundado com tráfego automatizado.

Mesmo que você esteja seguindo as práticas recomendadas, como respeitar o robots.txt, fazer muitas solicitações do mesmo endereço IP ainda pode levantar suspeitas. Como resultado, você ainda pode se deparar com os erros 403 Forbidden ou 429 Too Many Requests.

A melhor maneira de evitar isso é alternar seu endereço IP usando um proxy da Web.

Se você não estiver familiarizado com isso, um proxy da Web atua como um intermediário entre o seu scraper e o site de destino. Ele encaminha suas solicitações e retorna as respostas, fazendo com que o site de destino considere que o tráfego está vindo do proxy e não do seu computador real.

Essa técnica não apenas ajuda a ocultar seu IP real, mas também é útil para contornar restrições geográficas e muitos outros casos de uso.

Agora, há vários tipos de proxies no mercado. Para evitar ser bloqueado, você precisa de um provedor de alta qualidade que ofereça proxies rotativos genuínos, como a Bright Data.

Na próxima seção, você verá como integrar os proxies rotativos da Bright Data com o Pydoll para extrair páginas da Web com mais eficiência, especialmente em escala.

Integração do Pydoll com os proxies rotativos da Bright Data

A Bright Data controla uma das maiores redes de proxy do mundo, com a confiança de empresas da Fortune 500 e mais de 20.000 clientes. Sua rede de proxy inclui:

- Proxies de datacenter – Mais de 770.000 IPs de datacenter.

- Proxies residenciais – Mais de 150.000.000 de IPs residenciais em mais de 195 países.

- Proxies de ISP – Mais de 700.000 IPs de ISP.

- Proxies móveis – Mais de 7.000.000 de IPs móveis.

Siga as etapas abaixo e saiba como usar os proxies residenciais da Bright Data com o Pydoll.

Se você ainda não tiver uma conta, inscreva-se na Bright Data. Caso contrário, faça o login para acessar seu painel de controle:

No painel, clique no botão “Get proxy products” (Obter produtos proxy):

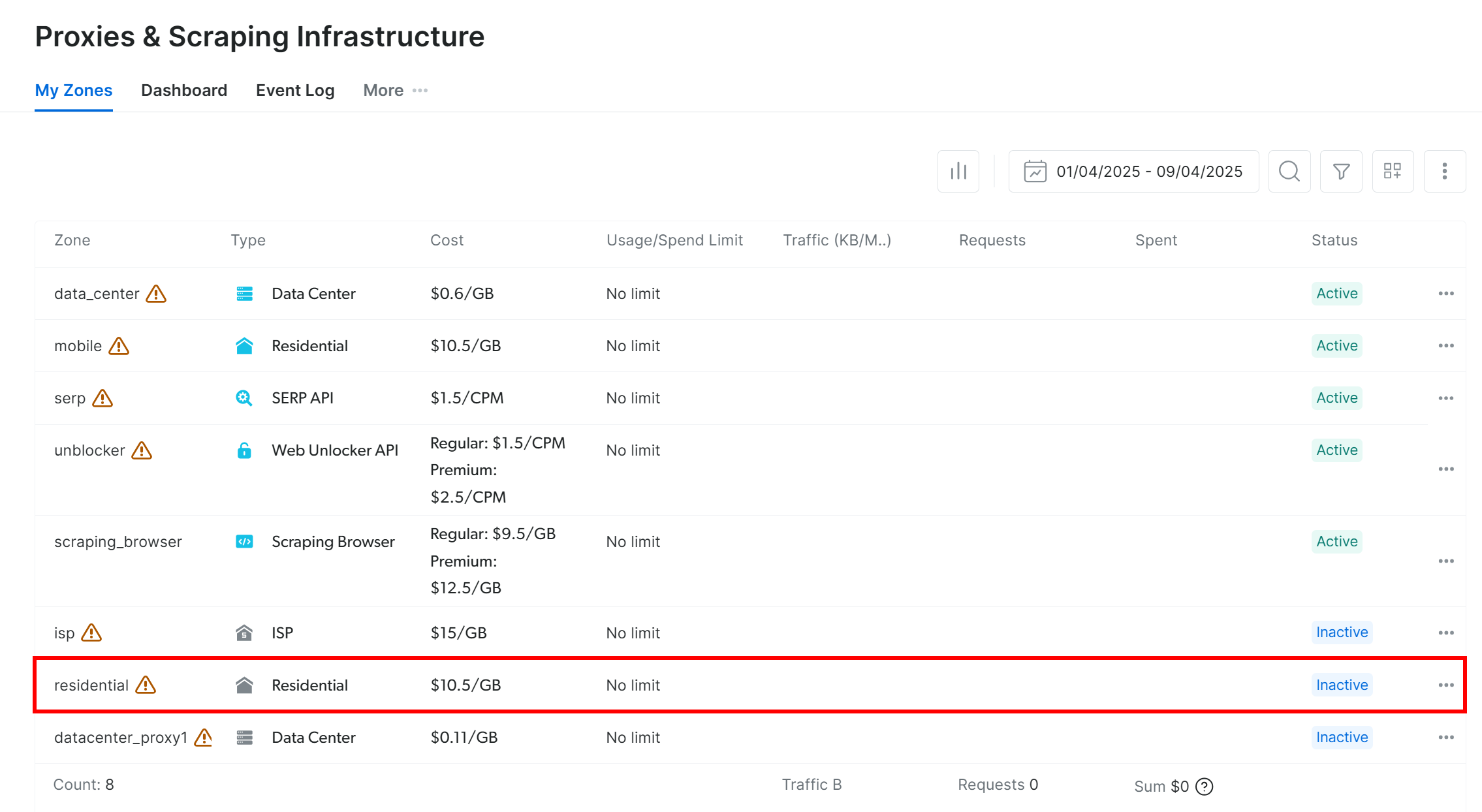

Você será redirecionado para a página “Proxies & Scraping Infrastructure”:

Na tabela, localize a linha “Residential” e clique nela:

Você chegará à página de configuração do proxy residencial:

Se esta for sua primeira vez, siga o assistente de instalação para configurar o proxy de acordo com suas necessidades. Para obter ajuda, entre em contato com o suporte 24 horas por dia, 7 dias por semana.

Vá para a guia “Overview” (Visão geral) e localize o host, a porta, o nome de usuário e a senha do seu proxy:

Use esses detalhes para criar seu URL de proxy:

proxy_url = "<brightdata_proxy_username>:<brightdata_proxy_password>@<brightdata_proxy_host>:<brightdata_proxy_port>";Substitua os espaços reservados (, , , ) com suas credenciais reais de proxy.

Certifique-se de ativar o produto proxy alternando o interruptor de “Desligado” para “Ligado”:

Agora que você já tem seu proxy pronto, veja como integrá-lo ao Pydoll usando os recursos de configuração de proxy incorporados:

import asyncio

from pydoll.browser.chrome import Chrome

from pydoll.browser.options import Options

from pydoll.constants import By

import traceback

async def main():

# Create browser options

options = Options()

# The URL of your Bright Data proxy

proxy_url = "<brightdata_proxy_username>:<brightdata_proxy_password>@<brightdata_proxy_host>:<brightdata_proxy_port>" # Replace it with your proxy URL

# Configure the proxy integration option

options.add_argument(f"--proxy-server={proxy_url}")

# To avoid potential SSL errors

options.add_argument("--ignore-certificate-errors")

# Start browser with proxy configuration

async with Chrome(options=options) as browser:

await browser.start()

page = await browser.get_page()

# Visit a special page that returns the IP of the caller

await page.go_to("https://httpbin.io/ip")

# Extract the page content containing only the IP of the incoming

# request and print it

body_element = await page.find_element(By.CSS_SELECTOR, "body")

body_text = await body_element.get_element_text()

print(f"Current IP address: {body_text}")

# Execute the async scraping function

asyncio.run(main())Toda vez que você executar esse script, verá um endereço IP de saída diferente, graças à rotação de proxy da Bright Data.

Observação: normalmente, o sinalizador --proxy-server do Chrome não oferece suporte a proxies autenticados de imediato. No entanto, o gerenciador de proxy avançado do Pydoll substitui essa limitação, permitindo que você use servidores proxy protegidos por senha.

Com os proxies rotativos da Bright Data, a rotação de proxy do Pydoll é simples, confiável e dimensionável!

Alternativas ao Pydoll for Web Scraping

O Pydoll é, sem dúvida, uma poderosa biblioteca de raspagem da Web, especialmente para automatizar navegadores com recursos integrados de desvio anti-bot. No entanto, ela não é a única ferramenta no jogo.

Abaixo estão algumas alternativas sólidas do Pydoll que vale a pena considerar:

- SeleniumBase: Uma estrutura Python construída sobre as APIs do Selenium/WebDriver, oferecendo um kit de ferramentas de nível profissional para automação da Web. Ele suporta tudo, desde testes de ponta a ponta até fluxos de trabalho de raspagem avançados.

- ChromeDriver não detectado: Uma versão corrigida do ChromeDriver projetada para evitar a detecção por serviços anti-bot populares como Imperva, DataDome e Distil Networks. Ideal para raspagem furtiva ao usar o Selenium.

Se você estiver procurando uma solução de raspagem da Web para fins mais gerais que funcione em qualquer site e ofereça suporte a várias linguagens de programação, confira nossos serviços de raspagem:

- Navegador de raspagem: Um navegador compatível com Selenium, Playwright e Puppeteer com recursos de desbloqueio incorporados.

- APIs do Web Scraper: APIs pré-configuradas para extrair dados estruturados de mais de 100 domínios principais.

- Web Unlocker: Uma API tudo em um que lida com o desbloqueio de sites com proteções antibot.

- API SERP: Uma API especializada que desbloqueia os resultados dos mecanismos de pesquisa e extrai dados SERP completos.

Conclusão

Neste tutorial de integração de proxy, você aprendeu o que é o Pydoll e como ele funciona. Exploramos como usá-lo para raspagem da Web em um site com JavaScript e vimos como resolver sua principal

limitação por meio da integração de proxy.

Você também entendeu por que usar o Pydoll sem um mecanismo de rotação de IP pode levar a resultados não confiáveis. Para obter um desempenho estável, segurança aprimorada e escalabilidade, você deve escolher um provedor de proxy confiável. Economize tempo e esforço indo direto ao melhor provedor de proxy do mercado, a Bright Data.

Crie uma conta e comece a testar nossos proxies gratuitamente hoje mesmo!