Os dados são um dos ativos mais valiosos da atualidade, e protegê-los se tornou uma das principais prioridades das empresas. Como resultado, os sites estão implementando medidas avançadas de anti-scraping para proteger seus dados. Se você deseja coletar dados com eficiência, é importante compreender essas técnicas antirraspagem. Este artigo abordará as técnicas populares de anti-scraping e discutirá maneiras de contorná-las!

O que é anti-scraping?

Anti-scraping refere-se a um conjunto de técnicas e ferramentas implementadas por sites para evitar a extração não autorizada de dados. Os sites empregam vários métodos para detectar atividades de raspagem, como o monitoramento do tráfego de entrada em busca de padrões incomuns, como solicitações excessivas de um único endereço IP.

Os desafios CAPTCHA são outro método comum usado para distinguir entre usuários humanos e bots automatizados. Essas são apenas algumas das muitas técnicas comuns de anti-scraping que os sites usam atualmente. Vamos discutir mais na próxima seção!

As 7 técnicas antiscraping mais populares

Vamos explorar as sete técnicas antirraspagem mais populares e as estratégias para superá-las.

1. Lista negra de endereços IP

A lista negra de endereços IP é um método comum usado por sites para limitar o número de solicitações que um único endereço IP pode fazer em um período de tempo específico. Essa técnica é muito eficaz na identificação e no bloqueio de Scrapers que enviam muitas solicitações.

Em primeiro lugar, é recomendável não usar seu endereço IP real para fazer scraping para contornar a proibição de IP. A melhor maneira é usar a rotação de IP por meio de Proxies rotativos premium. Isso envolve a alteração frequente do endereço IP para distribuir solicitações entre vários IPs, reduzindo a chance de detecção e bloqueio.

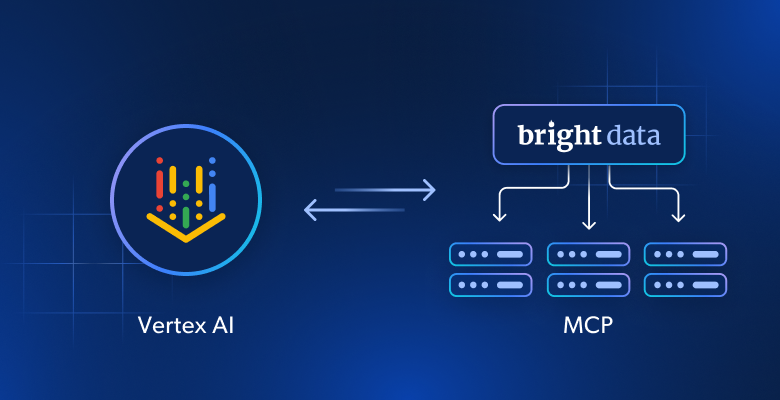

Se precisar de proxies confiáveis, rápidos e estáveis para o Scraping de dados, a Bright Data oferece várias opções adaptadas a diferentes casos de uso. Com milhões de IPs residenciais e de Proxy de datacenter, a Bright Data garante soluções de proxy confiáveis e eficientes.

2. Agente do usuário e outras filtragens de cabeçalho HTTP

A filtragemdo agente do usuário é outra técnica comum contra a coleta de dados. Os sites analisam a string “User-Agent” nos cabeçalhos HTTP para diferenciar e bloquear o tráfego não humano. Os Scrapers geralmente dependem de cadeias de caracteres User-Agent padrão que são facilmente detectáveis por ferramentas antirraspagem.

Da mesma forma, os sistemas antirraspagem podem bloquear solicitações que não incluam um cabeçalho Referrer, que contém o URL da página que iniciou a solicitação.

Outros cabeçalhos, como Accept-Language, Accept-Encoding e Connection, são normalmente enviados pelos navegadores da Web, mas raramente são incluídos pelos scrapers. Os Scrapers geralmente negligenciam esses cabeçalhos porque eles não afetam diretamente a recuperação de conteúdo.

Para contornar essas verificações, você pode alternar entre uma lista de cadeias de caracteres User-Agent que imitam navegadores e dispositivos populares e incluir cabeçalhos adicionais como os discutidos acima.

No entanto, os sites podem combater isso cruzando os dados do User-Agent com outros indicadores de comportamento, como padrões de solicitação e reputação do endereço IP. Essa técnica exige atualizações constantes da lista de strings User-Agent para permanecer eficaz, o que pode ser demorado e difícil de manter.

A solução definitiva para evitar essas complicações é usar a API Bright Data Web Scraper. Essa API de raspagem de última geração contorna sem esforço as tecnologias antibot com recursos como rotação automática de IP, rotação de agente de usuário e Proxies residenciais. Fazer solicitações automatizadas bem-sucedidas nunca foi tão fácil!

3. Desafios de JavaScript

Os sites geralmente usam desafios de JavaScript para impedir a raspagem automatizada. Esses desafios podem incluir CAPTCHAs, carregamento de conteúdo dinâmico e outras técnicas que exigem a execução de JavaScript.

Para enfrentar esses desafios, você pode usar navegadores sem cabeça, como o Playwright ou o Selenium, que executam JavaScript e interagem com páginas da Web como um usuário humano. No entanto, sistemas avançados de proteção contra bots, como o Cloudflare e o Akamai, apresentam alguns dos desafios de JavaScript mais difíceis do mercado. Para superar esses desafios, muitas vezes é necessário passar um tempo significativo mexendo em ferramentas em vez de se concentrar em escrever o Scraper. No entanto, é possível contorná-los usando o Navegador de scraping da Bright Data.

O Navegador de scraping vem com um recurso integrado para desbloqueio de sites, que se encarrega de lidar com os mecanismos de bloqueio automaticamente. Ele gerencia todas as operações de desbloqueio de sites nos bastidores, inclusive a Resolução de CAPTCHA, tentativas automáticas e seleção de cabeçalhos, cookies e renderização de JavaScript apropriados. Além disso, o Navegador de scraping se integra perfeitamente com o Puppeteer, o Selenium e o Playwright, proporcionando uma experiência completa de navegador sem cabeça.

4. Desafios CAPTCHA

Os CAPTCHAs são um sistema popular de proteção anti-bot que exige que os usuários concluam um desafio para verificar sua identidade humana.

Esses desafios podem envolver a identificação de objetos em imagens, a solução de quebra-cabeças ou a digitação de texto distorcido. Os CAPTCHAs são eficazes porque são projetados para dificultar a solução por sistemas automatizados.

Muitos serviços de CDN(Content Delivery Network), como Cloudflare e Akamai, agora incorporam CAPTCHAs em suas ofertas de proteção antibot. Isso ajuda os sites a apresentar automaticamente CAPTCHAs a usuários suspeitos, especialmente quando são detectados padrões de Tráfego incomuns.

Felizmente, os solucionadores de CAPTCHA foram desenvolvidos para resolver esse problema. Há muitos solucionadores de CAPTCHA disponíveis no mercado, que discutimos em detalhes em nosso artigo, Os 9 melhores solucionadores de CAPTCHA para Scraping de dados. Você pode analisá-los com base em fatores como velocidade, precisão, preço, tipos de CAPTCHAs que eles resolvem e integração de API para descobrir qual deles atende melhor às suas necessidades.

Com base em minha experiência, o Bright Data Web Unlocker se destaca em termos de taxa de sucesso, velocidade e capacidade de resolver vários tipos de CAPTCHA. Para obter mais informações, você pode conferir o guia detalhado sobre como ignorar CAPTCHAs usando o Web Unlocker.

5. Armadilhas Honeypot

Os honeypots são uma maneira simples, porém eficaz, de identificar e bloquear bots não sofisticados que não conseguem diferenciar entre conteúdo visível e oculto. Essas armadilhas geralmente incluem links ou formulários ocultos que são invisíveis para usuários humanos, mas detectáveis por bots. Quando um scraper interage com um honeypot, ele aciona o sistema antirraspagem para bloquear o scraper.

Para evitar honeypots, os scrapers devem analisar cuidadosamente a estrutura HTML das páginas da Web e evitar interagir com elementos que não são visíveis para usuários humanos, como aqueles com propriedades como "display: none" ou "visibility: hidden". Outra estratégia é fazer um rodízio de proxies para que, se um dos endereços IP do servidor proxy for pego em um honeypot e banido, você ainda possa se conectar por meio de outros proxies.

6. Análise de comportamento

A análise comportamental envolve o monitoramento das ações do usuário ao longo do tempo para detectar padrões que indiquem raspagem automatizada. Os bots exibem comportamentos previsíveis e repetitivos, como fazer solicitações em intervalos regulares, seguir caminhos de navegação incomuns ou acessar páginas em uma ordem específica. Os sites também analisam fatores como duração da sessão, movimentos do mouse e tempo de interação para identificar atividades não humanas.

Os sistemas antibot avançados utilizam o aprendizado de máquina para se ajustar às novas técnicas de raspagem. Ao treinar modelos em extensos Conjuntos de dados de interações de usuários, esses sistemas podem diferenciar com mais precisão entre comportamentos humanos e de bots. Essa abordagem adaptativa permite que os algoritmos de aprendizado de máquina evoluam em resposta à evolução das estratégias dos bots.

Pode ser difícil contornar esses sistemas, e você provavelmente precisará de serviços avançados de antirraspagem para acompanhá-los. O Web Unlocker é uma solução avançada baseada em IA e aprendizado de máquina. Ele foi projetado para enfrentar e contornar esses bloqueios. Ele usa o aprendizado de máquina para determinar os melhores métodos para contornar as defesas do site e emprega algoritmos treinados para aplicar configurações personalizadas de impressões digitais.

7. Impressão digital do navegador

A impressão digital do navegador é uma técnica usada pelos sites para coletar informações sobre o navegador, como resolução da tela, sistema operacional, idioma, Zona horária, extensões instaladas e fontes. Ao combinar esses detalhes, os sites podem criar um identificador exclusivo para seu dispositivo, que pode ser usado para rastrear e bloquear scrapers. Para evitar a impressão digital do navegador, você pode randomizar essas características para dificultar a criação de uma impressão digital consistente pelos sites. Para isso, você pode alterar seu endereço IP com frequência, usar diferentes cabeçalhos de solicitação (incluindo vários User-Agents) e configurar seu navegador headless para usar diferentes tamanhos de tela, resoluções e fontes.

Embora esses métodos possam funcionar em alguns casos, eles apresentam riscos e limitações. Para economizar tempo e esforço e garantir operações de scraping sem problemas, considere o uso de ferramentas como o Bright Data Web Unlocker ou o Navegador de scraping, que foram projetados especificamente para lidar com esses desafios de forma eficiente.

Conclusão

Este artigo abordou tudo o que você precisa saber sobre as técnicas populares de antirraspagem. Ao compreender essas técnicas e implementar táticas avançadas de evasão, você pode extrair dados de sites com eficiência.

Para obter mais orientações, temos um guia detalhado sobre Scraping de dados na Web sem ser bloqueado, no qual discutimos várias soluções para superar as restrições de sites.

Como alternativa, você pode simplificar o processo usando o Navegador de scraping de dados da Bright Data ou o Web Unlocker para acessar dados de qualquer site, independentemente de suas restrições. Comece a usar os produtos da Bright Data hoje mesmo com um teste grátis, registre-se abaixo!